分享到:

- 微信

- 微博

今年以来ChatGPT的热度一直不减,而国内的AI大模型创业赛道也在如火如荼展开,不少创新创业企业也在这里面加紧寻找自己的机会,加紧发力。国内企业如何找准定位,发挥自身优势?大模型开源意味着什么?未来又将形成怎样的行业格局?

本期嘉宾

邱锡鹏,复旦大学计算机科学技术学院教授,主持开发了开源自然语言处理工具 FudanNLP 和 FastNLP,获得了学术界和产业界的广泛使用。2023年,邱锡鹏团队发布类ChatGPT模型MOSS,是国内第一个发布的对话式大型语言模型。目前,MOSS模型已上线开源,促进人工智能模型研究和开源社区的生态繁荣。

特约评论员

资深人工智能专家

竹间智能创始人兼CEO简仁贤

技术迭代历经千锤百炼

刘晔:两位是从什么时候开始接触到AI大模型的这个技术浪潮,又什么时候开始去做自己的动作布局的?

邱锡鹏:虽然大模型对我们公众来讲可能是近期比较热的一个词,但从学术研究领域,其实从几年前就开始了,并且在两年前,有很多研究者就得出一个结论,就是所谓的规模定律,如果想要人工智能性能有所提升,它的规模要呈指数增长才可以带来那种线性的性能提升,所以对于研究者来讲,如果想要提升性能,它的规模就要不断上升,这就是为什么现在的模型就越来越大。

刘晔:所以我们叫它大模型。

邱锡鹏:大是一个相对的词,可能在几年前所谓的大,比如说亿这个级别就算大,放在今天,可能在百亿到千亿这个规模就是大模型。

刘晔:简总,我看到我们竹间在今年也推出了叫类ChatGPT技术的AIGC产品,从企业的角度,您是什么时候开始关注到大模型的技术方向,以及什么时候开始要把公司的发展方向和路线跟它来进行交融?

简仁贤:我们从2021年开始关注GPT2,GPT2它有大概有15亿的参数左右,一直到2022年的年中,6月、7月的时候,谷歌它其实有一个模型LaMDA的发布,有一个突破,所以那个时候我们就开始研究如何把我们的产品加上大模型的技术。一直到11月底,12月初的时候,ChatGPT出来了,世人终于理解到大模型怎么样去做。

刘晔:大模型作为一个技术和我们市场之间的交互好像真正被打通了。

简仁贤:是的。因为确实ChatGPT一出来以后,它就给你讲三个步骤,它是怎么训练的,它是怎么应用的,它是怎么得到结果的。GPT是怎么做出来的,它本身是没有开源的,所以全世界的人大家都在研究,特别是我们中国大陆这些科学家跟企业家们就开始在研究,它的绝大多数训练数据都是英文的,我们怎么做一个中文版的GPT?那么就有了类GPT这样一个词出现,就开始一直到现在,8个月当中,其实在国内的进步是非常飞快的,包括邱教授的MOSS,他们从以前到现在进步也是非常快,我们也在用MOSS在我们的底层,看看我们的产品怎么应用。

刘晔:MOSS是怎么思考自己在这个浪潮里面的战略部署和定位?

邱锡鹏:在2020年,我们就发现,当时大家在关注像谷歌的BARD这种理解式模型,我们就希望说能够用一个通用的模型,能把所有的自然语言处理,这种所有的任务都能给统一解决。所以就做了这方面研究,我们从那时候开始,也就开始做预训练。ChatGPT我记得推出的时候,很多人非常焦虑,当时网上很多的论坛上,都是说我们的差距非常大。但其实我们想一想,根据OpenAI它一贯的做法,它的模型应该非常简单,应该还是一个语言模型,所以我们就根据我们的经验,也在这方面做了一些尝试,然后在1月初的时候,复现了它的能力,因为对话能力是相对来说比较容易激发的,以及不断地与人类交互进行迭代,直接和用户去交互,然后能够让它不断地迭代,这就是我们后面为什么要推出这个MOSS,就是希望让大家能够通过它的使用,不断提升它的能力。

研发到落地任重道远

算力、算法、数据被称之为人工智能的“三驾马车”。算力是 AI 发展的基础设施,算力布局主要来源于芯片的采购布局;算法是 AI 解决问题的机制,不同的公司都有自己实现大模型的独特路径算法;数据则是算法训练的养料。在国内大语言模型的赛道中,不同企业和公司都会面临哪些不一样的难点?

刘晔:竹间的企业定位是什么?它为什么样的受众提供什么样的服务?

简仁贤:我们的使命是让所有的企业都能够有一个可以得到的,可以触及到的AI技术。这个不是只有大企业的专利,我是希望把它落到所有的中小企业。让技术能够变成产品,产品变成应用,应用变成服务去落地,最后我们再回归到学术研究,所以这是世界科技进步的一个闭环,我们所有的企业客户,他们服务的用户可能都有8亿到10亿的用户这么多了。

刘晔:我们说其实在AI大模型的生态圈当中,大家普遍会把它分为四层,底层是算力层,再往上是框架层,再往上是模型层,就像我们现在说的语言大模型等等模型层,再往上是应用层,MOSS应该定位在哪个层?

邱锡鹏:可能下面的几层,其实应该还有一层,应该是数据层。数据也非常重要,相当于MOSS它也是需要用到很多的数据,数据非常重要是因为不是所有的数据喂给模型都能带来收益的,那么在此期间,如何把那些具有高价值的数据挑出来,这个非常重要,那么另外一个就是框架,因为现在一个模型放在比如说一张GPU或者一台机器上都放不下的,在训练的时候,它可能放在近百台的这种机器上,那么这样的话,你如何把这个模型拆分,以及拆分完之后怎么去做它底层算法上的优化,其实都是非常重要的。

简仁贤:我是这样子看,我们底层最基础的是算力层,算力层这上面我们有个基础模型层, GPT这是一个基础模型,MOSS是一个基础模型,在基础模型上面我们还有叫做行业模型,是给一些ToC应用用的。那么在基础模型的部分,现在的趋势是会走向两种不同的形态,一种就是超大型的这种基础模型,它是面向C端去提供服务的,比如说像ChatGPT,它有一两亿的用户。另外一个我觉得是未来特别是企业还有创业公司主流的推动力,也就是能够拉齐创业公司在大模型的能力跟互联网公司拉齐的这样一个契机,就是开源的社区,包括MOSS也是一样。

刘晔:可以说开源为这个生态提供了一个基础设施,企业才可以在里面去做他们自己相关领域的进一步的创新。

简仁贤:比如像ChatGPT这样的一个模型它是不可能私有部署的,那企业要的是私有部署的一个模型,为什么?它的数据不能上传,它不可能上传它企业的机密数据到这种互联网式的超级大模型上面,现在企业的趋势就是用开源模型自己来做。那么ChatGPT用的大家都知道,1250万美金去训练,这个叫预训练。没有任何的企业有这么大的成本,除了超级巨大的企业,但它也没有这么多人跟数据去做,所以最好的就是拿这些预训练上面做微调训练。我们在做的就是如何帮企业这些模型能够训练到,微调到企业所需要的。

邱锡鹏:对我们学术机构来讲,我们面临的最大问题,肯定是来自于算力。

刘晔:据说复旦目前是有一千多块的芯片,这够吗?

邱锡鹏:对大模型来讲其实还是不够的,所以还需要有很多外部的企业一起来做,现在大家还是在追比如说它的3.5或者到4之间,我们因为做大模型,总归想要超过GPT4,那你想想,如果做GPT4,它号称是一个万亿模型,当然它的架构具体是什么,外面不知道,但是如果要训练出来GPT4,那它的算力的消耗要比现在可能再大十倍都不止,这样的话,对我们整个国内来讲可能算力都会是非常紧需的,这是一个层面。另外一个层面就是数据配方。那到现在为止,包括除了OpenAI之外,其他各家这种模型的表现来看,好像大家还都没有达到OpenAI的那个配方。

刘晔:数据配方,但这个配方它是不外传的。

邱锡鹏:对,不外传。这个都是需要投入资源去做实验的,即使是说我们知道别人已经做出来了,但如果我们自己去复现的话,还是要比较大的投入。

国内企业如何寻找最优路径

刘晔:在这个阶段,你面临的最大的焦虑来自于哪里?

邱锡鹏:我没有焦虑,我觉得就是说我们还是一步一步去做,我们就要去创造一些条件,然后能够去追得上。比如说我们算力不足,我们有可能找到一条其他的架构,比如说能够吞下非常大的上下文,这个能力非常重要,但在这些能力上,其实Transformer的架构并不是最优的,所以就给我们以某种程度上能够去找到一个新的路径超过Transformer这种体系的大模型。对Transformer来讲,它有个不足的地方,当它模型规模扩得非常大的时候,它对算力的消耗,其实也会变得更大,特别是比如说输入长度非常长的时候,它目前其实是没有办法做的,这就是它的一些架构带来的问题。如果我们能找到一条能很好地缓解这些问题的路径,我们就有可能得到一个比目前OpenAI的GPT4更好的模型,但这个确实没有特别明朗的路,要也要一步步去研究。

简仁贤:因为从ChatGPT开始推出来,让我们看到它非常多的这种能力,包括我自己在用,就常常会有这种所谓的涌现效果出来,那么这个时候你就会开始去思考,这样的通用大模型我们怎么去落地?所以企业现在很茫然,他们知道大模型很多能力,可是他们不知道如何去落地,这个时候我们是帮助它如何去落地。

刘晔:其实邱教授做的是提门槛,您做的是降门槛。

简仁贤:对,其实邱教授在做的是基础模型,我们要在基础模型上面去做模型,是可以到企业落地,转换成我们的收入,希望我们能够赚钱,再回馈到学术界,然后学术界再去投入基础模型,这样的一个正循环, 企业要落地,它很多并不需要很多世界的知识,比如说石油公司,它是不需要医药的知识,比如说医药公司它是不需要物流跟电商知识的,所以它不需要那么多的数据去训练。

邱锡鹏:因为大家对于大模型有一个误解,就是说所有的企业都需要像ChatGPT这样的模型,其实不是的。它是有任务的,你根据这些任务去训练一个模型,可能都不需要超过130亿参数的模型,就可以达到这些任务在ChatGPT这样一个超级大模型85%甚至90%的能力。

简仁贤:大的模型企业用不到,大部分人它是用不到的,你不能每一件事情都是用对话去问,你一定要赋能到它的业务里面去。所以我就在想我们要做的不是去做像ChatGPT、OpenAI这样的事情,我们要做的让大模型落地企业的最后一公里路。企业落地,我是提出来三个步骤,第一个步骤是企业要先找到我们叫唾手可得的场景,比如说在销售的场景,做销售的助手,比如说在客户服务的场景做客服,比如说在HR的场景帮他做员工的上岗培训,这些场景都是唾手可得,马上就可以去应用了。那么它根本不需要像ChatGPT这么大的一个模型就可以做得到的,第二点,企业应该去找到的是什么样可以帮它带来high impact的场景,high impact就是说它企业目前遇到的困难是以前它用传统技术做不到的,它可以用新的人工技术去达成的。那么第三个才是,企业再去做自己真正的大的通用模型,这样子才能够帮助企业真正建立企业长久的这种基础大模型,这样子才有办法去解决算力、数据还有模型的这个三角形的问题,达到最佳化。

赢家通吃还是群雄逐鹿?

ChatGPT横空出世,拉开了大语言模型产业发展的序幕。海外市场,OpenAI、微软、谷歌、Meta等巨头动作频频。中国市场也百花齐放:百度、阿里、华为、腾讯、360公司、商汤、京东、科大讯飞、字节跳动等巨头厂商结合自身业务及战略布局,陆续宣布研发或已发布大语言模型产品。然而大语言模型厂商商业化路径各有差异,在未来,整个行业的格局会出现赢家通吃还是群雄逐鹿,目前尚未可知。

刘晔:其实今年我们看到很多的大厂都在纷纷布局,目前国内的AI大模型赛道当中,目前入场的这些企业,两位有没有特别关注的?

邱锡鹏:对。刚才您提到后发优势,其实他们有优势的,包括比如说在今年很早期的时候,像百度它就宣称做中国的ChatGPT文心一言,他们那个时候做的时候没有太多参考,包括像我们做的时候一样,就是凭过去的一些经验,还有对这个领域的认识,然后做出来的,你放到今天做就又不一样了。

刘晔:有一些人烧过的钱,走过的路,你还是可以抄点作业的是吗?

邱锡鹏:对,所以在这个基础上,比如说放在今天,我相信像百度重新再做这件事,它可能会做出更优秀的文心一言,这些都是来自于大家的研究,包括原来MOSS怎么走的,我们也都分享给大家。但是真正要成为企业的生产力工具,这个我们其实还是和Open AI的GPT43.5还是有一些代差的,比如说我们聊天看起来大家都不错,但是越往后走会越难。其实大家每家做起来都会很难。也是希望,可能学术界也会扮演非常重要的角色。

刘晔:现在其实数据之间还是存在一些壁垒的。

邱锡鹏:对,但是如果有些企业可以去共享这些用户交互的数据,因为如果它开放的话,它的数据量是非常大的,其实学术界它会基于这些数据去研究怎么样去迭代,能够达到一个更好的效果,我是觉得这样是一种双赢,一个非常好的合作。

刘晔:今年是国内AI大模型的元年,未来逐渐洗牌以后,可能会是一个什么样的行业格局?

邱锡鹏:我觉得因为它是一个非常重要的基础设施,它将来的生态可能就是像Open AI这样的一家,它做得非常好,但还有很多开源的,大家拥抱一两个开源的,大的比较好的基座模型,然后共同来开发,非常像比如说目前的iPhone和Android这样的。

刘晔:所以底层是这样的,类似于现在的Android和iPhone。再往上呢?

邱锡鹏:再往上的话,我觉得像比如说竹间智能这样的公司,它就可以去在上面做一些垂域的应用。最终,我想通用人工智能确实是会在将来的几年之内就会到来,一方面大家是面向企业的,每个企业都可能有一个企业大脑,另外还有一个我觉得非常重要的可能是面向个人的,比如说我们个人的助理,可能会比以往的这些个人助理它会更加智能,帮助我们处理很多日常生活中的事,以及比如说像智能家居等等,它可能会类似于电影中的AI形象,可能比我们想象中的会更早地来到我们的现实生活。

刘晔:所以其实我觉得ChatGPT出来以后,大家既兴奋,也有很多的焦虑,可能所有人都需要去开放我们的心态,但是真的要实现自我的迭代,自我的变革。

简仁贤:我就套一句黄仁勋黄总,英伟达的CEO讲了一句话,我每一天都是处于兴奋跟焦虑,两种冷跟热的交替状态当中,当我想清楚了怎么克服我的焦虑,我就有一个新的契机之后,我又兴奋了,兴奋完又以后,又有一个新的技术又创新出来了,我就焦虑,那我怎么办?又变成兴奋了。所以就是在这样冷跟热的交替当中我们有了创新。

美国股市的AI热潮看似乐观 未来趋势却令人怀疑

股价翻倍 人形机器人却遇“订单荒”? 高盛调研揭示产业链企业零订单现状 上市公司回应称“静待客户指引” 业内:定义“产能过剩”为时尚早

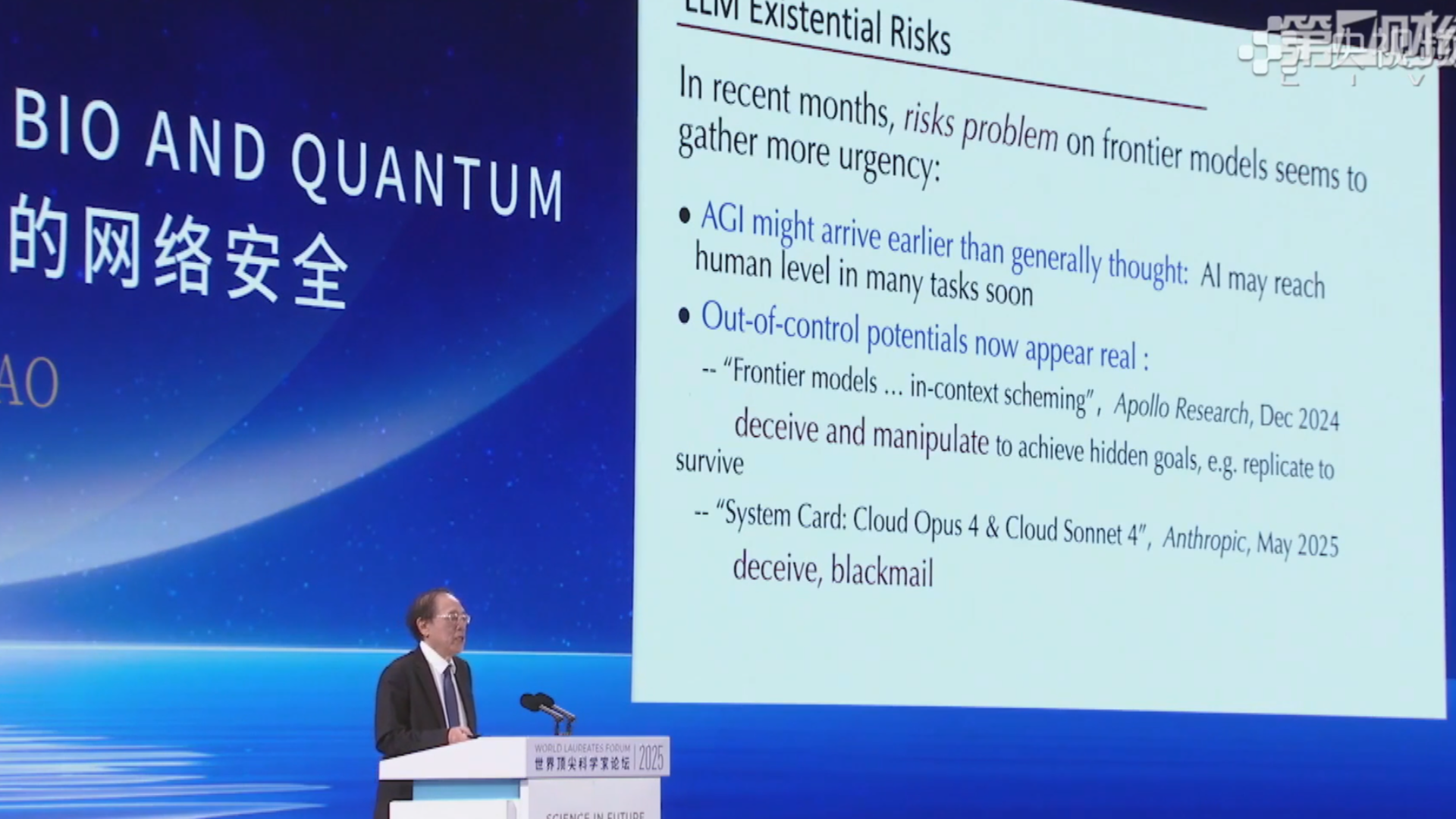

姚期智:大语言模型在极端压力下可能擅自发动核攻击 甚至将责任推卸给他人

大语言模型可能会做出一些灾难性的决策。

凯文·凯利:中国有望引领全球可持续发展与AI 三大前沿趋势重塑技术未来

德国科学院院士罗兰德•艾尔斯:中国对医疗人工智能贡献巨大,DeepSeek是一个最佳证明

近日,以“共享创新共塑未来:构建开放合作的全球科技共同体”为主题的2025浦江创新论坛在上海开幕。本届论坛规模和参会嘉宾数量均达历届之最,共有来自美国、德国、瑞士等45个国家和地区的300多家机构的550余位嘉宾参与。