分享到:

- 微信

- 微博

近日有报道称,OpenAI的热门聊天机器人ChatGPT每天要消耗超过50万度电,马斯克也曾预测,2025年全球电力将陷入短缺。而除了电力,大模型也十分“耗水”。本期视频,一起来揭秘大模型背后的惊人数字。

大模型之所以“大”,在于其参数巨大,谷歌LaMDA模型参数高达1370亿,GPT-3模型参数高达1750亿,GPT-4更是被曝包含了1.8万亿参数,而规模越大,对算力的需求便越多,如训练GPT3.5 需要用到约3万颗英伟达A100芯片。

算力的运行和生产往往离不开电力。一颗英伟达H100芯片最大功耗达到700W,以利用率61%计算,每颗芯片每年将消耗约3740度电。到2024年底,全球范围内将有350万个H100 GPU投入使用,电力总耗令人震惊。

服务器芯片在运行过程中会产生大量的热量,如果热量控制不当,会对数据中心的稳定运行造成影响,因此,科技巨头们需要耗费大量水资源来为数据中心降温。到2027年,全球AI所需的水资源可能会达到惊人的66亿立方米。

而AI发展,不仅耗水、耗电、耗芯片,还特别耗人。不仅是科学家,还包括AI训练中的数据标注师。大模型依赖数据训练,但要先做好数据采集、筛选、标注和质检。著名科学家李飞飞曾为了训练AI,通过亚马逊的在线众包平台在全世界167个国家雇佣了5万人,标注了1500万张图片。而直到今天AI训练依然需要大量的数据标注师。

“吞”水、“吃”电,耗芯又耗人——揭秘大模型背后的惊人数字。点击视频,一看究竟!

文章作者

专访复星医药王兴利:用数字模型为患者“试药”?AI有望让这一设想变成现实

不到10%价格做到接近国际领先模型 “AI六小虎”抢跑港股IPO 记者对话MiniMax、智谱高管谈技术路线 | 一探

近期,中国人工智能赛道迎来重要资本节点。稀宇科技(MiniMax)与智谱同日通过港交所上市聆讯,两家被外界称为“AI 六小虎”的代表性企业,正式迈入资本市场关键阶段。在资本市场之外,更受关注的是两家公司在大模型技术与商业化路径上的选择。第一财经记者独家对话MiniMax与智谱高管,从模型架构、算力效率到实际应用场景,拆解中国大模型企业在现实约束下的技术取舍与发展逻辑。更现场、更财经,一探究竟。

从3个月到2周!AI药物创新“最后一公里”被打通 2025顶尖科学家论坛见证科研范式变革

10月25日,2025世界顶尖科学家论坛在上海举行。在论坛期间的生命科学大会上,一款功能分子AI发现平台正式发布。第一财经记者采访该平台各参与方了解到,通过应用该平台,苗头化合物的发现周期可从以往的约三个月,缩短至两周。同时,记者也观察到,在本届顶尖科学家论坛,此类AI for Science的科研范式正在成为一种新的潮流。在这一范式下,科学研究的数据用以训练AI模型,而AI则作为研究工具,反过来加速科学探索的进程,二者形成相互促进的关系。

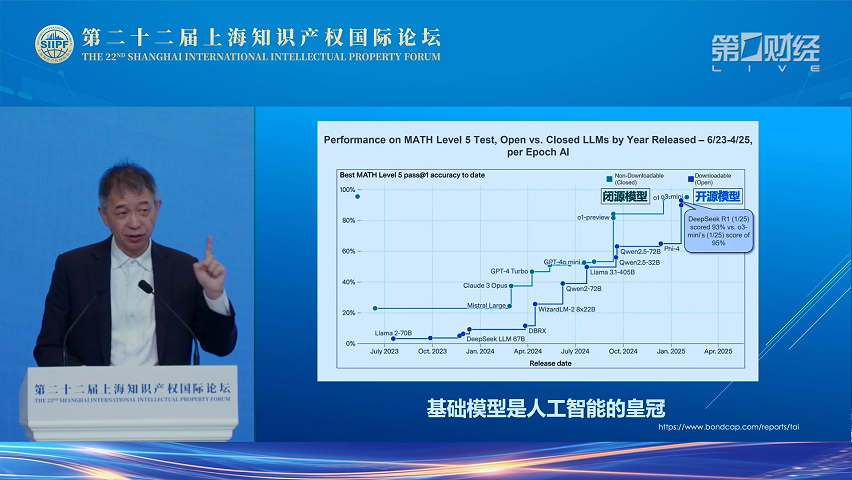

王坚:目前开源基础模型的能力已与闭源持平 中国做出了巨大贡献 千问大模型与DeepSeek能力远超Meta的Llama模型

10月18日,在第二十二届上海知识产权国际论坛上,之江实验室主任 、阿⾥云创始⼈王坚表示,以前人们往往认为开源基础模型的能力会一直低于闭源模型的能力,但中国在其中做出了巨大贡献,让开源模型的能力与闭源模型的能力持平了。并且阿里云的千问大模型和DeepSeek能力已经远超过Meta的Llama模型。