分享到:

- 微信

- 微博

{{aisd}}

AI生成 免责声明

在资源不足且分布不均的医疗领域,人们开始把希望寄托在机器上,医疗成为人工智能(AI)赋能的热门领域。

前瞻产业研究院数据显示,2017年中国医疗人工智能市场规模超过130亿元,并有望在2018年达到200亿元,医疗人工智能空间广阔。

但现实情况是,AI进入医疗领域,头上有一面穿不透的天花板。

近日,在博鳌亚洲论坛全球健康论坛大会召开期间,国家卫健委远程医疗管理与培训中心办公室主任,国家卫健委基层远程医疗发展指导中心办公室主任卢清君接受了第一财经的专访。他表示,虽然医学人工智能是发展的大趋势,但目前AI还有很多不成熟的地方,如果大规模在临床应用的话是很危险的。

第一财经:人工智能(AI)最近正处于风口,到处可见AI被应用到各领域,医疗领域也不例外,特别是一些互联网诊断和远程手术,有很多资本进入和概念炒作,你如何看待AI在医疗领域的使用?

卢清君:首先要一分为二地看待医学人工智能。从积极的态度看,医学人工智能目前是发展大趋势,数字化医疗,大数据计算技术的发展,使得人工智能已成为一个行业发展的必经之路和重要的方向。从需求上来说,无论是大医院的医生,还是基层医生,都需要一些辅助用具,都需要一些决策的数据依据。参照人的记忆能力,是没法完成现在数字化这种大规模运算、大规模记忆存储能力的,这是人脑的局限性,机器的存储正好弥补了人类的短板。所以在很大一部分程度上,我们对AI有很大的期待,将来在各个领域,他都会发生重要的作用。

但回过头来说,我们要清醒地看待AI现在发展的历程。

第一,目前人工智能还处在非常初级的阶段,有很多不成熟的地方,包括它的数据模型的建立,数据的来源,以及知识模型和知识标准,这些方面都很初级。换句话说,这些目前都是工程师建立的模型,很少有临床医学的专家去参与这个过程。所以在这个阶段,AI还存在很多缺陷,很多风险,如果大规模临床应用的话是很危险的,因为医疗是不能出错的。IT界有个流行语叫做开着飞机修飞机,而医疗是不行的,一定得把飞机修好了才能开上去,所以这是一个行业之间的特点决定的,它和电商及其他领域都不太一样。

第二,现在的人工智能是基于国际开源的一些公用的模型和算法,它的优势局限在语音识别、图像识别,对于很多其他的逻辑模型还有很多短板,目前还很难建造一个非常符合临床医学规律的数据模型。所以,这就需要更多的数学家参与到医学AI的开发中来。我们的医学数据模型没有建立的话,那么将来AI的应用场景就会非常受局限,会很肤浅。

所以在目前这个状态下,很多人提出,既然AI很肤浅,很初级,那么用在基层医疗上是不行的,这是一个风险所在。基层医生是没有判断能力的,你把这样一个机器给他,他无法判定我需要采取机器的建议还是拒绝机器的建议。或许很多大专家有这个能力,但是基层医生偏偏没有这样的能力。如果机器的建议本身有风险呢,基层医生是没法判断的,这对诊断疾病来说会有潜在的风险。

在AI不太成熟的时候,我们不主张大规模在医疗领域去推广,但是我们需要实验,需要一个局限性的、小范围的、特定环境下的实验,目的是为了帮助AI工程师们去建立更好的数学模型。

第一财经:这么说,在医疗领域大面积铺开AI使用,除了风险很大之外,还是存在很多制约?

卢清君:确实是这样。现在AI的整个设计逻辑还存在短板,它是基于一种完全可控的、可知的、可预测的数学模型,换句话说它是符合现代简单数学逻辑的,1+1=2的这种数学逻辑去建立的模型,而我们的临床疾病很多情况下不是如此清楚的数学逻辑,他是个因果关系,这其中会涉及很多潜在的干扰因素,还有未知因素,所以现在目前建立起来的AI模型还无法模拟临床上这种因果关系。简单一句话就是目前的AI不具备逻辑推理能力,因为人还不知道自己的逻辑推理是怎么算出来的。

我们看到科学界有很多关于AI的报告出来,对AI的一些优点和弊端都做了一些相关鉴定。一方面,它具备大规模的运算能力、存储能力、深度搜索能力,也具备快速学习能力。它目前解决的包括连接到精确控制和精细的远程操控,这些能力解决的是一个劳动密集型的问题,解决的是重复性的、简单逻辑很确定的工作关系。

从生物学上来说,我们对人的这些跳跃型思维还不太掌握,如何实现模拟逻辑推理过程还没有认知。从思维方式上来说,积极的深度学习是一个连续性的学习,我们在人脑上叫连续性思维,但目前机器无法做到的是跳跃性思维,比如说我们人有个事解决不了,睡了一天觉后,第二天早上突然灵光一现,找到了解决方案,这种跳跃性的思维目前从生理学上怎么诞生的,我们并不知道,这是脑科学还没有解决的问题,所以无法用机器去模拟这种跳跃性思维,这时候就无法完成逻辑推理层面上的治病过程。。但是临床诊断是需要一个逻辑推理能力的,这是AI的短板,所以目前整个AI的运用还有很大的风险。

从AI发展的技术上来说,技术本身存在很多缺陷,比如说鲁棒性的问题。什么叫鲁棒性呢,系统面临决策产生的干扰因素所表现的稳健性。人在判断错误的时候,他会有一些其他因素来补偿,他会及时去终止自己的错误行为,会有一些潜意识的反应去防范一些恶性问题的发生。

所以科学界说,人的鲁棒性是好的,后果不是很严重。而机器的鲁棒性是差的,它出现了错误自己都不知道是错误,会继续错下去,带来的后果很严重,典型的案例就是波音737max8飞机,一个非常简单的程序错误导致了一个灾难性的后果,因为它没有人工修正的过程,这就是鲁棒性差的一种表现。其实那个问题有多大呢,很小,max8工程师花了10分钟就修复完了。所以我们目前对AI认识必须要看到背后的风险。

第一财经:有人说AI的最大优势就是自我学习和深度学习,随着时间的发展,你说的这些问题,会不会慢慢破解?

卢清君:从目前AI界存在的一些瓶颈问题看,很多主要表现在其他方面。第一,它采取的深度学习这种方式目前已经到了天花板了,深度学习的前提是要基于大规模的规范化的、客观的、正确的数据去支撑,也就是说要有很好的教材,而我们现在医疗界是不可能有这种教材的,为什么?因为都是过去式,而且很多过去的病例又未必具有普遍性,因为每个病人都有个性化,所以在这种情况下,AI是没有学习材料的,至少没有一个合格的学习材料。

我们在研究历史形成的大数据的时候,系统无法剔除原来犯过的错误,机器学了,它也是剔不出来的。这不光表现在我们的临床病历,还表现在学术论文上,学术论文每年都会有一些撤稿的论文,也就是哪些被后来检验是错误的论文,那么这些撤稿的论文机器都学进去了,它是无法撤除的。按照机器学习理论,它自动建立起了知识模型,它的错误的模型就已经在里面了,已经形成支撑结构了,你很难给它剔出来,因为人不知道它是怎么建立起来的,这感觉就像拿着机器学习搞成了科学算命,就像一个黑盒子,不知道它怎么进去的,不知道它怎么出来。所以你不知道他结果的可信性,那么你就无法判断这个结果在临床上是不是可以使用。这是目前最大的一个AI风险,所以我们要研究到底在医疗上采用什么样的方式去建立AI模型,这是当下目前科学界最紧迫的一个议题。

第一财经:那你觉得当前的这个AI技术能够在医疗界哪些领域应用呢

卢清君:目前在一些浅显的模型上是可以做的,比如一些临床路径,和一些常规的诊疗方案,面对常见病多发病的一些简单诊断,包括用在大众上,就像一些大众指导,简单的一些医学知识咨询,因为这些知识我们是可以通过行业的专家共识,行业标准,还有一些国际的规范,根据这些东西去建立疾病模型,AI可以摈弃那些错误的数据在里面。但是,像一些深度学习,像临床病例,很多都是没有经过数据清洗,数据标准的。

所以在医疗的AI应用上,实际上我是不太建议从深度学习做起的,而是应该从一个知识库知识结构,就是我们已经确定的知识结构去做,而不是从一个过去发生的案例来深度学习,这是两个方向。科学院几个院士也在提出,目前的AI深度学习不适合在医疗上的应用。

如需获得授权请联系第一财经版权部:banquan@yicai.com

美貌陷阱:为何健康女性被定义为“病态”丨元旦书摘

在束缚女性的所有枷锁中,对美貌的苛求或许是最顽固、最隐秘、最难以摆脱的一个。

政企学研共筑合力《2025AI+健康(医疗)产业应用图谱》闭门研讨会成功举办

数亿元资本涌入AI医疗赛道,商汤医疗值不值30亿?

医疗科技公司都在争夺各种数据入口,一方面积极与各大医院合作,抢占医院端入口,另一方面也在抢占患者端入口,希望把低频的医疗行为变成高频的健康咨询问诊行为。

长三角健康消费器械产业发展分会成立

旨在进一步提升健康商品和服务供给质量,打造新业态新模式新场景。

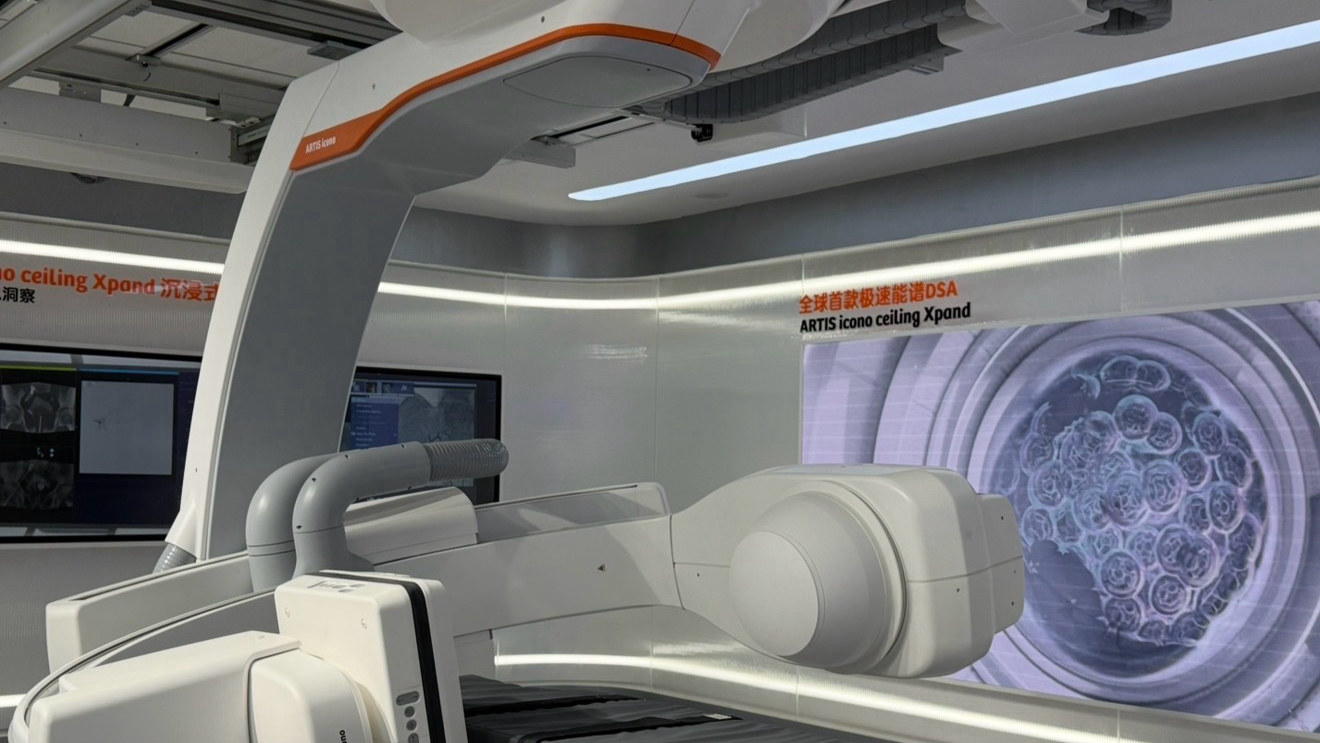

聚焦进博会|AI赋能医疗器械,跨国厂商研发重心转向中国

如今的CT和磁共振等设备已经能够覆盖影像诊断、模拟定位、直线加速器及治疗软件的全链路癌症诊疗解决方案。