分享到:

- 微信

- 微博

{{aisd}}

AI生成 免责声明

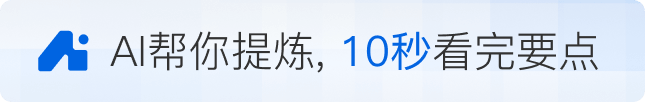

刚落幕的2025世界人工智能大会暨人工智能全球治理高级别会议(WAIC)上,华为展台展出一整面昇腾384超节点的“墙”。记者看到,不断有观众与之合影。

超节点(SuperPod)成为本届WAIC的热点。除了华为,WAIC期间,上海仪电还联合曦智科技、壁仞科技、中兴通讯发布国内首个光互连光交换GPU超节点光跃LightSphere X,新华三推出H3C UniPoD S80000超节点,超聚变也展出了超节点方案。业内人士预计这波超节点热度会延续下去。

超节点是一种应对大算力集群芯片协同问题的方案。通过整合算力芯片资源,在一个超节点内构建低延迟、高带宽的算力实体,让单个超节点尽可能大地释放算力,避免芯片空闲,提高算力利用效率,支撑千亿乃至万亿参数模型的训练和推理。

即便是在单颗算力芯片制程受限的情况下,超节点技术也能让集群性能继续提升。壁仞科技OCS超节点项目相关负责人董朝锋告诉记者,在国内,做超节点已经是个明显的趋势,随着算力集群迈入“万卡协同”时代,探讨未来算力的构建范式演进非常重要。

超节点为什么火了?

从千卡集群到万卡集群、十万卡集群,算力芯片集群越来越大,是因为大模型越来越大,参数量已经迈向万亿。要怎么做好算力支撑,业内不得不思考这个问题。

英伟达是较早布局超节点技术的代表厂商。英伟达GB300 NVLink72可以将72个GPU和36个CPU整合到单一平台。近期在布局超节点的国内厂商则包括AI芯片厂商和服务器厂商。

有芯片业内人士向记者举例,一个万亿参数模型训练可能是这样的:粗略估算需要1万张GPU,但为了具备容错能力,要有超过1万张GPU。此外,要具备多个超节点,每个超节点内有几十张GPU,超节点内部也有冗余、容错能力,包括秒级容错和分钟级故障恢复能力、调度能力。调度能力是指将万亿参数模型的训练分布到每个GPU上做并行计算。

在这个万卡算力芯片集群中,超节点是一个很核心的概念。董朝锋告诉记者,如果单机8卡可以跑一个70亿参数的模型,当模型参数达到千亿、万亿,就需要更多GPU服务器。然而,传统AI服务器的scale out(横向拓展)互连由于线性度关系会导致算力性能的损失。在没有超节点的情况下,机柜之间由于线性度的影响会有算力性能损失,导致“1+1”无法等于“2”。但如果有超节点,则能保证单个节点内的性能最优。

有从业者告诉记者,如果没有超节点,一个机箱单机8卡,只能做到每2卡之间的带宽、通信延迟一致。董朝锋告诉记者,超节点有两条路线,一是scale out横向拓展,二是scale up纵向拓展。纵向拓展即在一个节点内尽可能多地增加GPU,例如一个千卡集群中,每64卡是一个超节点,在这个超节点中,可以做到卡间、机间的通讯带宽、通讯基本一致。

超节点技术中,光互连是主流方向之一,属于光通信范畴。光互连有全光交换、全光互连、光互连电交换路线。业内人士告诉记者,与光互连电交换相比,光互连光交换可以依托于光芯片,将电交换能力转化成光交换能力,光的切换是纳秒级,因此可以灵活切换拓扑且带宽较高。光通信可保证集群与集群之间高带宽、低延迟。

此次上海仪电联合曦智科技、壁仞科技、中兴通讯发布的超节点方案就采用分布式光互连光交换技术,该方案使用曦智科技的光互连光交换芯片和壁仞科技的GPU液冷模组,搭载中兴通讯的AI服务器。新华三推出的超节点产品则基于以太协议和PCIe协议,可适用多种算力芯片,适用万亿级参数大模型训练和推理。此外,WAIC上展出的华为昇腾384超节点可通过总线技术实现384个NPU(神经网络处理器)之间的大带宽低时延互连。

超节点在国内越来越受到关注,其背后,是因为超节点技术成为提升芯片制程之外,另一条能提高芯片集群性能的路径。随着摩尔定律面临“失灵”风险,推进芯片制程演进的难度增大,提升单颗芯片的计算性能面临挑战,业界需要寻找新的方法来继续提升算力。

董朝锋告诉记者,在芯片提升制程之外,超节点技术是能让集群性能提升的方法之一。短期内,国产AI芯片在制程工艺上与世界顶尖水平存在客观差距,国内厂商可以通过超节点方案部署更大规模的芯片集群来弥补单点性能的不足,以量补质,也能通过超节点技术让集群性能继续提升。其中光芯片也可以不依赖于高制程。

有业内人士告诉记者,英伟达的互连方案相对封闭,自有GPU、配套软硬件,国内一些厂商则在做开放生态。相较英伟达全套自研的路线,国内还没有类似英伟达这样成系统的技术体系。近期国内很多厂商包括服务器厂商都在推广超节点,各家路线各不完全一样,还需要时间来证明技术优劣。总体而言,国内光通信技术在全球比较领先,与海外先进水平相比没有明显代差。

应对市场竞争

今年国产芯片在AI服务器中的占比已在提升。TrendForce集邦咨询数据显示,去年国内AI服务器芯片中,外购部分(包括英伟达、AMD)所占市场份额为63%。该机构最新预计,外购部分今年的占比将降至49%。

即便如此,海外芯片厂商仍重视中国市场。英伟达CEO黄仁勋在本月早些时候表示,英伟达将推出面向中国市场的全新GPU。

除了通过互连技术优化提升芯片集群的效率,国内芯片厂商在芯片设计、市场策略上也在寻找方法,应对市场竞争。

墨芯人工智能此次在WAIC上展出了S40等计算卡。该公司相关负责人告诉记者,与英伟达的竞争不能只在产品性能上下功夫,还可以采取迂回竞争的策略。英伟达的GPU是通用型GPU,可用于训练和推理,不会针对一些垂直行业专门作出改变,但国产芯片可以有一些改变。该公司的产品针对推理做了优化,集中面向AI推理场景,例如边缘计算一体机,在特定场景下可以有更快计算速度和更低功耗。

上述公司相关负责人告诉记者,很多芯片厂商主要面向稠密计算需求,该公司则采用软硬件结合的策略,在软件算法上采用稀疏计算技术。与稠密计算的卡不同,面向稀疏计算的卡对制程的要求不高,可以采用12nm制程。目前公司的产品比较适用于特定场景的小模型运算,后续将推出的新产品则定义为广义稀疏的产品,适用于大模型计算。

其他一些国产芯片厂商也避开了与海外AI芯片巨头的直接竞争。

云天励飞同样选择了AI推理场景。该公司在WAIC期间宣布将全面聚焦AI芯片,未来将重点围绕边缘计算、云端大模型推理和具身智能领域布局。云天励飞董事长兼CEO陈宁表示,云侧推理更多考虑多用户并行情况下的芯片硬件采购成本、集群电费等运营成本,边缘计算则对芯片硬件采购成本更敏感,且更注重芯片与场景结合时的有效算力。他判断,以AI大模型和各类AI算法、推理芯片为核心的AI技术,将在未来五年重新定义人类所有的电子产品。

后摩智能近日则推出新一代芯片,面向端边场景。该公司新一代端边大模型AI芯片后摩漫界M50在INT8精度下的算力为160TOPS,在bFP16精度下的算力为100TFLOPS。目前该公司的芯片面向平板、PC等消费终端,以及智能语音会议系统、运营商边缘计算场景。该公司还采用存算一体技术,解决传统芯片数据传输慢、功耗较高的问题。

后摩智能创始人、CEO吴强表示,定位端边大模型计算,一定程度上避开了和巨头竞争高壁垒产品和已固化的市场,此外,还可以发挥存算一体技术的优势,在新兴的AI PC、智能语音设备、具身智能等新兴赛道找到位置。

如需获得授权请联系第一财经版权部:banquan@yicai.com

文章作者

对话独角兽 | 沐曦支招国产GPU突围:生态是支点,用户是核心

沐曦认为,当前核心挑战在于缺乏端到端平台能力,需通过真实项目迭代持续提升技术水平。

上海公布重磅文件:量产L4级汽车,拓展自动驾驶开放区域

上海将培育具有行业领先水平的自动驾驶大模型,加快推进高级别自动驾驶引领区建设。

上海一个月5家AI企业上市,5500亿产业“护城河”全链开花

不同于其他城市单点突破的模式,上海正在构建一个AI完整“生命体”。

天数智芯上市,四家国产GPU公司齐聚资本市场

天数智芯在收入增长的同时,仍未实现盈利。

上海又一GPU“四小龙”上市,集成电路第一城规模超4600亿

2025年全年产业规模同比增长24%,五年产业规模翻了一番多